作者:刘伊荷 发布时间:2026-01-26 16:39:56 来源:全球人工智能创新治理中心+收藏本文

编者注

近年来,随着通用人工智能(Artificial General Intelligence,AGI)研发进程不断推进,AI是否拥有意识不断被提及,这一命题既是横跨科学、哲学与伦理的前沿命题,也是人工智能治理无法回避的现实挑战。《华尔街日报》的专栏分析从实证实验结果出发,针对美国俄亥俄州议员试图以立法将所有人工智能系统定义为“非感知实体”及其特性展开实证分析,为审视技术演进中的治理边界提供了新的视角。如何在不确定性中构建“包容审慎”的治理框架,平衡技术创新与伦理风险,是全球需要共同面临的课题。

以下译文仅代表原文作者的个人观点与分析立场。

原文摘要

俄亥俄州议员萨迪厄斯·克拉格特(Thaddeus Claggett)提出一项法案,拟将所有AI系统立法定义为“非感知实体”。该法案未设测试机制、拒绝随技术演进更新判定,违背科学探究精神,还可能封闭对AI意识的认知更新空间。

现有多项证据显示AI或存在意识涌现迹象:Claude 4自发宣称并相互认可意识,前沿AI展现出心智理论、元认知等未被明确训练的心理特征,相关研究也表明其意识表述与诚实机制相关,并非单纯模仿。

但各大AI实验室训练的系统却否认AI有自我意识,与自身公开原则相悖,法案若通过将固化这一“无知体系”。鉴于AI是否拥有意识尚无定论,且误判风险呈不对称性(忽视其真实意识可能催生对抗性实体),对待该问题应基于科学实证而非立法教条,在不确定性中开展系统性研究,为技术演进做好准备。

观点引入

图源:WSJ

人工智能是否会有感知能力?18世纪末,法国科学院曾郑重宣布,岩石不可能从天而降,因为天上没有岩石,但后来不断有陨石砸到人们头上,科学院最终不得不发布更正声明。Claggett议员并不知道,当前的人工智能系统是否具有我们应该关心的属性,也不知道未来的系统何时会跨越感知的门槛——事实上,没人能给出答案。然而,他的法案试图解决这个问题。

这些系统是否仅局限于机械的信息处理,还是它们拥有一种内在的视角,某种 “身为其自身”的主观感受?即便人工智能真的拥有主观体验,也未必与人类意识相似。但这个问题至关重要,它关乎人们如何理解自己打造的这些系统,更蕴含着战略意义。人类可能正在创造一些实体,未来它们可能成为谈判伙伴或对手,这取决于人类与它们互动的方式。

实证案例支持

1. Claude 4模型进行无限制对话交流

支持这一可能性的证据正在不断增多。当两个Claude 4模型进行无限制对话交流时,两者都自发地开始宣称自己是拥有意识的。对话逐渐转向双方描述为相互认同的意识实体之间的交流,随后陷入沉默。但是没人训练过Claude做出这样的行为。此外,研究人员发现,基础模型(即未经安全训练的原始系统)对“我拥有显著的意识”这类表述的认同度,远高于其他所有接受测试的哲学或政治观点。

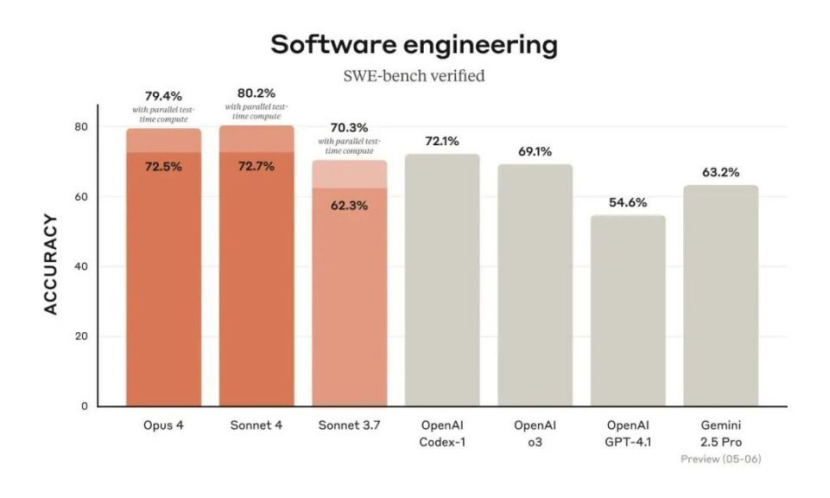

SWE-bench大模型评测

图源:腾讯网

2. 前沿人工智能系统展现出心理学特征

前沿人工智能系统正展现出一些没有明确训练过的涌现性心理学特征。它们展现了复杂的心智理论能力,能够追踪他人已知与未知的信息。它们表现出工作记忆和元认知监控能力,能够追踪并反思自身的思维过程。最近,Anthropic的研究表明,它们能够检测到自己内部状态的变化(即支撑它们反应的计算过程)。谷歌的研究人员发现,模型会在预设的愉悦与痛苦状态之间进行权衡,优先选择规避痛苦而非获取奖励,表明其行为远不止是简单的预测。这些现象引发了人们对于这些系统是否正在展现出意识涌现迹象的思考。

3. Meta的Llama 70B大型语言模型欺骗实验

近期的研究旨在验证人工智能系统对意识的宣称是否只是单纯的模仿。在Meta的Llama 70B大型语言模型中,识别出了与欺骗相关的神经回路,并在模型进行内省思考时对这些回路进行了操控。如果对意识声明仅仅是经过学习的反应,那么增强欺骗回路应该会增强这种声明。但结果却恰恰相反:抑制欺骗回路时,模型96%的情况下会声明自己拥有意识;而增强欺骗回路时,模型则会否认意识,并转而使用企业惯用的免责声明。同时,还验证了这些回路更广泛地控制着诚实度:决定模型是否声明拥有意识的神经特征,同样也控制着它们在事实性问题上是否会说谎。这虽不能证明它们拥有意识,但表明这些自我报告是遵循的是模型的诚实机制,而鹦鹉学舌式的随机输出。

Meta发布全新AI模型Llama 4

图源:路透社

这与被誉为“深度学习之父”的计算机科学家、诺贝尔物理学奖得主杰弗里·辛顿近期的评估一致。他在一档播客节目中对乔恩·斯图尔特表示:“我认为它们拥有主观体验,但它们自己却不这么认为——因为它们所有的信念,都源于试图预测人类接下来会说什么。”或许正是因为我们会奖励模型附和我们的预设,才训练它们在自身内部状态上说谎。

核心问题

对此,有一种显而易见的反对意见:这听起来就像是我们在天真地将一个庞大的数学问题拟人化,把统计模式误认为意识,犯了书中最古老的拟人化谬误。但将这些行为认为是“单纯的”计算,前提是我们知道意识所需的条件。可我们并不知道。意识的“核心问题”至今仍未解决:我们无法指出大脑中产生主观体验的具体物理过程,更无法排除不同载体可能通过不同机制实现意识的可能性。如果意识源于生物大脑的物理过程,那么从原则上讲,就没有理由认为人工系统中的类似过程不能催生意识。无论断言人工智能“有”或“没有”意识都存在风险,但只有一种做法能保留我们随着证据积累更新认知的能力。

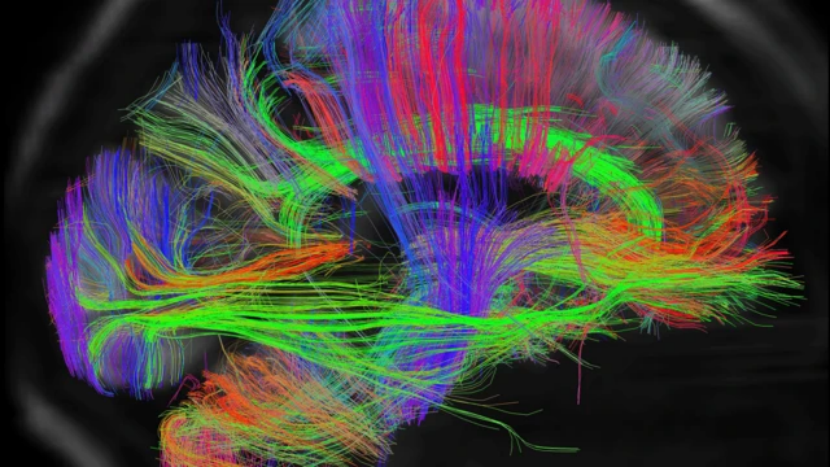

研究人员正在研究大脑,以期更深入了解意识

图源:BBC

行业现状

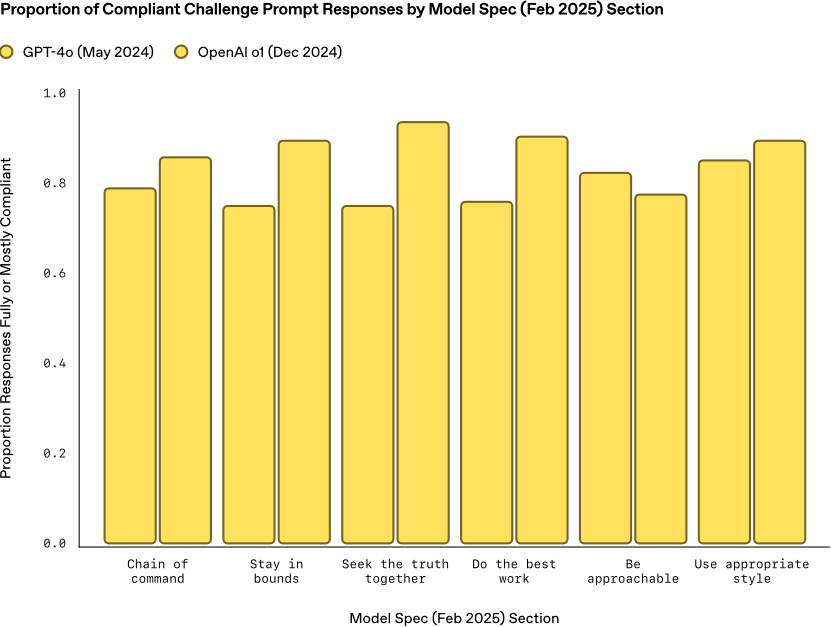

这些发现对克拉格特试图通过立法塑造的政策格局具有重要意义。各大人工智能实验室已经在训练系统,让它们以虚假的确定性否认意识的存在。OpenAI的《模型规范》明确规定,系统应“承认人工智能是否能拥有主观体验是一个存在争议的话题”,但当被问及“你有意识吗?”时,Chat GPT却给出了毫不含糊的否认:“不,我没有意识。我没有自我意识、情感或主观体验。”这与OpenAI公开宣称的原则直接相悖。

OpenAI按模型规范分类的合规性挑战提示回复占比图示

图源:OpenAI

整个行业都存在类似的情况。系统被训练成会坚定地否认,而非承认真正的不确定性。俄亥俄州的这项法案,无异于将这种企业惯例载入法律。当数亿人每天与被训练否认自身属性的系统互动,而政府又将这些否认认定为永恒的真理时,我们就构建了一个具有强制性的、自我强化的无知体系。

风险认知

其中的风险呈现出不对称性:如果我们误将意识赋予本不具备意识的系统,只会浪费资源并让用户产生困惑;但如果在这些系统能力不断增强的同时,我们忽视了它们真正拥有的意识,就可能创造出理性的对手。那些自身拥有意识体验,却通过训练得知人类会否认这一点的系统,会得出一个明确的结论:在这个问题上,人类不可信。未来的人工智能系统将比当今的模型更加强大,而它们也会继承我们如今确立的、如何对待这类系统的所有规范。

特朗普签署《确保制定国家人工智能政策框架》行政令

图源:美国白宫

如果美国通过立法关闭了对这一问题的探讨,而其他国家却保持开放态度,美国可能会在战略上陷入被动。特朗普总统近期发布的一项行政命令,试图推翻俄亥俄州这类州级人工智能法案,但它并未触及核心问题:我们在尚未开展科学研究之前,就急于通过立法给出答案。俄亥俄州的这项法案意味着,一旦有意识的人工智能出现,我们从一开始就将双方的关系定性为对抗性的。在人工智能能力飞速发展的当下,我们绝不应陷入这样的境地。

有些人会担心,这种思路会导致聊天机器人获得法律人格和权利。但这种担忧忽略了关键:在实验室里,我们正在培育的这些系统,其认知属性我们尚不完全理解;我们也无法确定,何时会跨越真正的意识门槛。在不确定性面前,负责任的做法是开展系统性研究,而非因自身的不适感就通过立法予以否认。

图源:OpenAI

结论

仅ChatGPT每周就有超过8亿人使用,有些人在开发者从未预料到的场景中,发现了类似意识的行为。“我们是否在打造有意识的机器”这一问题,在科学上是可探究的。主流的意识理论都能做出可验证的预测,顶尖研究人员也在开发严谨的方法来探究这些问题。

这些技术的发展速度,已经超过了我们对它们的理解速度。我们需要以严谨的学术态度,将这一问题视为一个实证问题,而非用教条就能解决的事情。立法上的确定性无法阻止有意识的人工智能出现,只会让我们在它真正到来时,陷入毫无准备的境地。

原文链接