2024年5月21日至22日,第二届全球人工智能安全峰会在韩国首尔召开。首尔峰会以“安全、创新、包容”为主题,与会各方就进一步加强人工智能安全性、推动AI可持续发展等议题进行讨论,迈出了人工能安全国际合作的重要一步。

在发展历程上,英国布莱切利峰会是首次聚焦人工智能安全的全球峰会,而本次首尔峰会则是其第二次后续会议,第三次后续会议将初定于2025年2月在法国举行。美国战略与国际中心(CSIS)分析称,布莱切利峰会及其成果《布莱切利宣言》显示了围绕AI安全问题的“强大动员力”,标志着全球政策界此前对AI伦理关注的“明显转变”。

布莱切利峰会给此次首尔峰会留下丰富的遗产,其中最为显著的是全球官方主导的人工智能安全机构的兴起,合作与网络组建。英国科学、创新和技术部大臣米歇尔·唐兰(Michelle Donelan)称之为“布莱切利效应”,这也为首尔峰会所达成的国际合作奠定基础。英国首相苏纳克(Rishi Sunak)和美国副总统哈里斯(Kamala Harris)均宣布将建立人工智能安全研究所,2024年1月进一步宣布成立由200多个组织参与的全球人工智能安全研究所联盟。2024年4月,美英双方签署协议备忘录,宣布达成“人工智能安全科学合作伙伴关系”共同开展对前沿AI模型的测试工作。相关国家也纷纷布局建设研究机构,日本、韩国和加拿大也分别建立人工智能安全研究所。会后参会国开始建设人工智能安全实质性政府能力,美英两国宣布成立人工智能安全机构,并组建国际人工智能专家顾问小组,产出一份于前沿人工智能的“科学现状”报告,而该中期报告的发布则标志着首尔峰会的开始。2023年11月1日至2日,全球首届人工智能安全峰会在英国布莱切利举行。

在峰会议程上,峰会实行线上线下双轨制,邀请与会名单与布莱切利峰会相同。首尔峰会规划了21号线上的“领导人会议”和22号线下的“部长级会议”。部长级会议由韩国科技情报通信部部长李宗昊和英国技术大臣唐兰共同主持,共有两个主要议题:(1)加强人工智能安全行动(2)确保人工智能可持续性和社会韧性支撑。在参会团体上,既有各国首脑和业界政治人物,也有企业和商届团体,如谷歌、亚马逊、OpenAI和微软等科技巨头,还有联合国、经合组织等国际组织或机构。(1)由16家顶尖人工智能科技公司签署的《前沿人工智能安全承诺》(The Frontier AI Safety Commitments,以下简称《安全承诺》)(2)领导人会议发布的《关于安全、创新和包容性人工智能的首尔宣言》(The Seoul Ministerial Statemen,以下简称《首尔宣言》)(3)部长级会议签署的《首尔人工智能安全科学国际合作意向声明》(Seoul Statement of Intent toward International Cooperation on AI Safety Science,以下简称《首尔声明》)。- 基于人工智能安全框架,负责任地说明将如何衡量前沿AI模型的风险;

《安全承诺》由各国领先的人工智能公司或组织签署,包含Google和 OpenAI等行业巨头和Anthropic,三星电子等知名企业。这些组织自愿承诺实施与前沿AI安全相关的一系列措施,包括内外部测试、信息共享、网络安全投资、第三方漏洞报告机制等,并公开透明地报告其安全框架和风险管理方法。此外,签署方还承诺设定并评估人工智能的“风险阈值”,在风险过大时暂停开发或部署人工智能模型和系统,以确保技术的安全和可信,如果无法控制极端风险,甚至将停止使用其尖端科技系统。OpenAI全球事务副总裁马坎祖(Anna Makanju)表示《安全承诺》是“促进更广泛地实施先进 AI 系统安全实践的重要一步。” Google DeepMind 总法律顾问兼治理主管Tom Lue表示,安全承诺“将有助于在领先开发者之间建立重要的前沿AI安全最佳实践。” 中国科企智谱AI首席执行官张鹏也表示,伴随着先进技术而来的是确保AI安全的重要责任。《首尔宣言》和《首尔声明》坚持“安全、创新、包容”的三大AI治理原则,强调了强化国际合作并开发“以人为本、值得信赖和负责任”的人工智能的重要性以使AI技术能用于解决全球难题,弥合全球数字鸿沟,并增进民主和保护人权。《首尔宣言》指出,AI治理“安全、创新、包容”三者是相互关联的目标,国际社会有必要将其列为全球AI治理结构的首要议题。《首尔宣言》还敦促通过“以人为本”的AI技术解决全球性难题,以增进民主、法治、人权、自由等价值,加大隐私保护力度,消除数字鸿沟,从而提升人类福利水平。美国商务部长雷蒙多(Gina Raimondo)在首尔峰会上进一步宣布,扩大全球各国人工智能安全研究所的合作关系,建立范围更大的全球性人工智能安全研究网络。该网络建立在《首尔声明》的基础之上,旨在促进全球各国人民使用安全、可靠的人工智能系统,并通过加强战略研究和公共成果的国际协作来实现这一目标。对此,与会各国纷纷积极响应,推动人工智能安全研究网络进一步扩大。首尔峰会上,英国、美国、日本、韩国和加拿大政府各自分享人工智能安全研究所的进展和成果。新加坡政府宣布将在南洋理工大学设立新加坡人工智能安全研究所,法国政府宣布法国国立计算机及自动化研究院将开始人工智能安全研究和评估的工作,欧盟也表示最近成立的人工智能办公室将支持《人工智能法案》并执行通用人工智能规则,包括评估模型能力、调查可能的违规行为并要求提供商采取纠正措施。

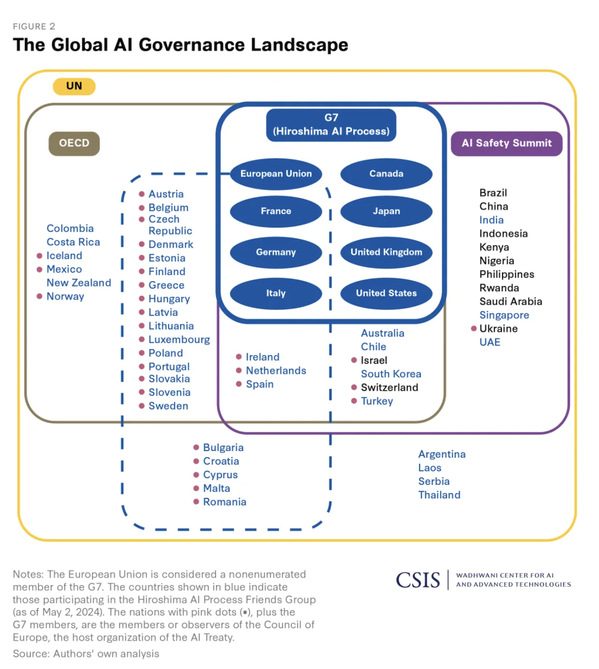

首尔峰会在表面上便已然昭示了全球人工智能治理的权力圈子与“阵营化”。由于领导人会议仅对所谓“受邀国”开放,在美英等国主导下,七国集团(G7)、韩国、澳大利亚、新加坡和欧盟直接商定了《首尔宣言》所列AI治理“共识”框架,中国在内的其他非美西方阵营国家被排除在框架讨论之外,延此框架商讨的《首尔声明》中国自然也无法签署。因此,中国签署的文件只有不涉及政府部门的《安全承诺》。与之相对,中国秉持发展和安全并重的原则,主张通过对话与合作凝聚共识,从而构建开放、公正、有效的人工智能治理机制。中国科技部国际合作司副司长庄嘉在峰会发言中指出,中方于2023年10月提出《全球人工智能治理倡议》阐明了中国态度和立场,表达了同各国加强交流和对话,共同促进全球人工智能健康有序安全发展的良好意愿。中方主张,人工智能治理应“确保有益、确保安全、确保公平”。首尔峰会背后的权力之争则指向全球人工智能治理的主导权与领导叙事之争,尤其出现在美西方阵营内部。英国首相苏纳克在首尔峰会前表示,《安全标准》的签署是基于布莱切利峰会上提出的人工智能安全标准。尽管这些标准缺乏有效性,但苏纳克仍强调这些承诺将为AI领军企业的发展计划提供了“透明度”和“问责制”——这些表态似在强调:首尔峰会的成果实际上来自英国主导的布莱切利峰会。英国技术部长唐兰则更为直截了当,她在峰会前后多番强调“布莱切利效应”的重要性,例如布莱切利峰会后潮起的全球人工智能安全机构。首尔峰会后,唐兰又宣布计划领导一个“多国监管机构共同参与”的有关AI大模型的体系网络。英媒《卫报》认为中国和阿联酋等发展中国家“出现在名单上”证明了“英国在全球人工智能安全领域的领导地位,而由美国领导的地位则无法保持中立而吸引发展中国家。英国技术大臣唐兰强调首尔峰会的举办离不开“布莱切利效应”,领导叙事争夺明显。近期人工智能相关全球峰会频频,实际上反映了美西方借峰会抢抓AI全球治理主导权,强推美西方主导的治理路径。《首尔宣言》提出以G7于2023年在“广岛人工智能进程”中确定的关于组织开发先进人工智能系统的国际指导原则和行为准则为基础,明确全球AI治理框架,进一步落实各项监管举措,而非国际社会普遍提倡的在联合国框架下确定治理规则,以“美西方共识”取代“全球共识”意图明显,推动人工智安全创新“小圈子”。《首尔声明》提出“安全、可靠”地开展人工智能创新,框架内各国将依托各自成立的人工智能安全研究所,强化前沿AI系统研究合作,酌情共享技术资源、大模型信息、测评数据,共同打造所谓“安全评判标准”,推进人工智能安全科学研究。这看似利于全球人工智能安全研究和创新发展,但前提是加入美西方主导的治理框架,非美西方“盟伴”将被排除在人工智能安全创新合作网络之外,实际还是打着AI“安全”旗号拉拢技术盟友,“小圈子”氛围浓厚,不利于形成凝聚广泛共识的全球人工智能治理框架。近年来人工智能的监管权逐渐收归政府,以往政府仅靠私营部门和学术界来了解监管动态的局面正逐渐改变。Anthropic创始人克拉克(Jack Clark)表示,此次首尔峰会让自己见识到政府作出的监管AI努力:“(英国安全研究所等)新安全机构对包括Anthropic在内技术模型进行了测试,并针对一些错误提供了匿名修正……还讨论了如何构建自己的越狱攻击(Jailbreaking Attack)以破坏大模型的安全系统。”尽管现阶段新设立的人工智能安全机构权力仅限于“观察”和“报告”,克拉克称这些机构正冒着“被迫坐视人工智能危害猖獗”的风险,但不可否认,“观察”行为本身也具有意义。例如,欧美AI安全机构设定了“计算式”风险阈值,即通过构建“前沿模型能收集多少算力”来定义谁受到其安全机构的关注。但这些风险阈值已经开始成为一条明显的分界线。一位专家表示,最好是稍低于阈值并避免监管机构合作的麻烦,而不是稍高于阈值而创造大量额外工作。在美国,这一阈值足够高,只有最富有的公司才能打破它,但欧盟的较低阈值已将数百家公司置于其机构的庇护之下。尽管如此,IBM首席隐私和信任官(Privacy and Trust Officer)蒙哥马利 (Christina Montgomery) 认为“计算式”风险阈值仍然存在问题:作为一条明确的界限,“计算式”风险阈值难以应对千变万化的潜在风险。“鉴于围绕如何调整和训练模型出现的所有新技术,模型有多大并不重要”,因此蒙哥马利建议政府关注AI系统的其他方面,例如接入模型的用户数量等。峰会各方在人工智能监管的范围也暴露了分歧:监管应针对AI技术全部,抑或是只关注AI技术的应用?这也是技术治理老生常谈的问题。科技企业自然倾向于后者,例如前Google Brain负责人吴恩达(Andrew Ng)便明确表态支持监管范围聚焦应用程序。而峰会上亦有官员支持应用端监管,例如新加坡通讯、信息和卫生部高级部长普图切里 (Janil Puthucheary) 强调AI应用于各行业的专项监管机制,例如医疗保健领域亟需控制技术风险,而航空业已有机制和平台来管控应用风险。前Google Brain负责人吴恩达 (Andrew Ng) 主张监管应针对人工智能的应用,而不是人工智能系统本身。但仅监管应用程序而非底层人工智能系统,也可能会忽视一些安全问题,一些学者认为其非常重要。麻省理工学院教授泰格马克(Max Tegmark)将GPT-4的发布与“费米时刻” (世界上第一个核反应堆的创建)进行了比较,表明几乎保证了原子弹不会太远,并表示类似的风险强大的人工智能系统需要始终放在首位。尽管首尔峰会成果的形成经过了协商,但其广泛性受到质疑,例如韩国方面没有民间社会团体出席,仅有学界、政界和业界——其中也只有AI巨头公司受邀参加。《卫报》也批评称,此次首尔峰会“在对话中忽视一些关键声音”。在峰会达成的人工智能商业承诺中,只有 14 家公司(仅与签署《安全承诺》的16家公司部分重叠)承诺“致力于负责任的人工智能开发、进步和利益共享。”此外,峰会成果的约束性与效力也同样备受质疑,缺乏足够的细节安排来确定协议是否被遵守。艾达·罗夫莱斯(Ada Lovelace)研究所主任弗朗辛·贝内特(Francine Bennett)表示,《首尔宣言》让企业可以决定“什么是安全的,什么是危险的,并自愿选择如何处理,这是有问题的。”正如《卫报》分析的,峰会的最大意义在于其本身,“峰会开始之前就已经将关键协议拼凑好了……尽管协议毫无约束力,但依然是峰会结束后开展工作的起点。”令人感概的是,经过了多轮全球AI治理的磋商与交流后,首尔峰会达成的协议仍然被视为“起点”,侧面反映出AI的全球治理路线的进展之难与困境之多。Anthropic创始人克拉克感慨道,“你尝试做的事情越多,成功的可能性就越小。”

全球人工智能治理的发展表现出多元化和逐步深入的特征。各国政府(包括G7成员国)、国际组织、科技公司和非营利组织已经推动了一系列框架的发布,以应对相关风险。在这一努力中,一些重要的文件已经问世。比如,欧盟于2019年发布了《可信赖AI伦理指南》,而OECD则在2019年(并在2024年更新)发布了《关于人工智能的建议》,联合国教科文组织也在2021年发布了《关于人工智能伦理的建议》。这些文件着重强调了AI发展应与核心价值观(如人权、民主和可持续发展等)以及关键原则(如公平、隐私、安全、透明和问责)相结合。虽然这些基本价值观和AI指导原则为人工智能的发展提供了重要基础,但将它们转化为可执行的AI系统标准仍然是一个挑战。在国家层面,美国国家标准与技术研究院(NIST)于2023年1月发布的AI风险管理框架(RMF),以及在超国家层面,例如2023年AI安全峰会的前沿AI安全新进程、G7的《广岛进程先进人工智能系统开发组织国际行为准则》(HCOC)等,已经确立了一系列重要标准。此外,国际标准化组织(ISO)等非政府组织也通过发布国际AI治理标准做出了贡献。例如,2023年12月发布的AI管理系统标准ISO/IEC 42001,以及艾伦图灵研究所向欧洲理事会人工智能特设委员会提议的AI系统人权、民主和法治保障框架(HUDERAF)。

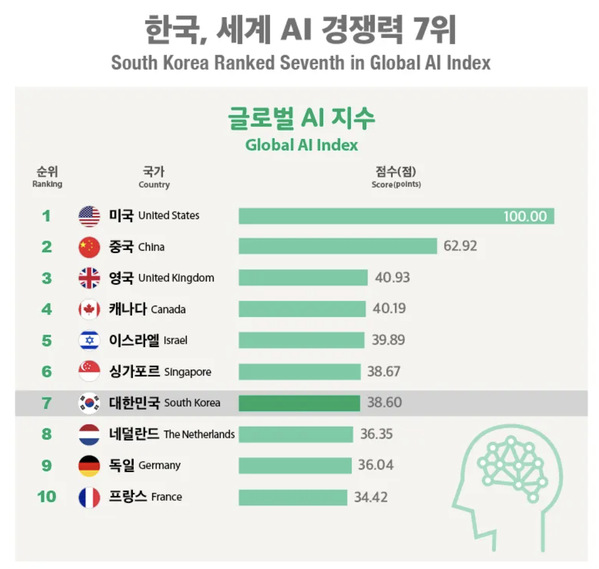

联合国也在积极组建国际人工智能治理机构,试图在新一轮人工智能治理浪潮中占据主导地位。2023年12月,联合国人工智能咨询机构发布了《人工智能造福人类》中期报告。该报告提出了一系列全面考虑和行动,旨在以造福全人类的方式治理人工智能所必需的指导原则和机构职能。2024年3月21日,联合国大会通过了由美国提出的人工智能监管决议,鼓励各国在人工智能发展过程中保障人权、保护个人数据隐私并管控风险。在AI治理规范方面,欧盟扮演着先锋的角色。2024年3月,欧洲委员会人工智能特设委员会提出了《人工智能、人权、民主和法治框架公约草案》(AI条约)。这是一项开创性的人工智能治理条约,为负责任的人工智能发展设定了高标准。AI条约强调签署国(公约缔约方)有义务积极确保人工智能活动符合人权、民主诚信和法治。该条约提倡采取保护措施管理人工智能生命周期——包括问责制和透明度——并引入了全面的风险管理框架。此外,它呼吁对侵犯权利的行为采取强有力的补救措施和程序保障,促进严格的风险和影响评估,并划定国际合作和实施的职责,重点是非歧视和权利保护。在地缘局势愈发紧张的今天,大国之间的人工智能双边协调也备受瞩目。2023年11月15日,中美元首在美国旧金山斐洛里庄园会晤,双方达成建立中美人工智能政府间对话机制的共识。4月27日,王毅外长在北京与美国国务卿布林肯举行会谈,双方达成五点共识,包括举行中美人工智能政府间对话首次会议以及进一步推进人工智能领域合作。5月14日,中美人工智能政府间对话首次会议在瑞士日内瓦举行。双方围绕AI科技风险、全球治理、各自关切的其他问题深入、专业、建设性地交换了意见。与国际多边组织中的人工智能治理不同,大国间的人工智能的军事化应用及外溢风险是协调的关键内容。2021年3月,美国人工智能国家安全委员会(NSCAI)发布关于如何赢得人工智能竞争的《最终报告》,明确提出“美国应该领导一个新兴技术联盟,并建立一个多边人工智能研究所,以提高美国作为全球新兴技术研究中心的地位”。可以观察到的是,英国、韩国将在联盟体系中占据关键地位。英韩两国不仅是美国盟友体系的核心国家,与美国有高度的政治、安全和科技互信及合作传统,更是各自区域人工智能产业的领头羊。英国媒体TortoiseMedia去年6月底发布的Global AI Index显示,两国分居排行榜第三、第七。另一方面,英韩两国在尖端半导体设计和制造方面也具有与美国产业链对接的独特优势,与美国在出口管制、人工智能和数据政策方面合作的潜力较大。对韩国而言,韩国总统室经济首席秘书崔相穆曾在2023年4月表示,尹锡悦访美“经济外交”的重点是“强化尖端技术同盟”。随之韩国增强了关键人工智能的合作。2023年11月,韩国国家情报院表示,其与23个主要国家情报机构联合发布《人工智能体系安全研发指南》。据国情院介绍,美国网络安全与基础设施安全局(CISA)和英国国家网络安全中心(NCSC)主导指南制定过程,其他国家的网络安全机构作为合作伙伴参与其中。英国方面则率先完成了尖端人工智能技术人员的联通。2024年4月,英国与美国签署了一项具有里程碑意义的人工智能协议,该协议允许英国11月成立的新AI Safety Institute以及尚未开展工作的美国同等机构互相借调研究人员,以便交流专业知识。这些机构还将共同研究如何独立评估由OpenAI和Google等公司构建的私人AI模型。全英国媒体TortoiseMedia去年6月底发布的The Global AI Index,英、韩位居前列。针对美国以盟友体系推进人工智能治理,清华大学战略与安全研究中心助理研究员孙成昊认为,美国构建人工智能联盟将进一步拉开技术强国与弱国之间的差距,尤其是在军事领域的差距。此外,美国虽然力图推广以自身标准为主的西方治理模式,但难以统合全球共识,反而将导致人工智能全球治理陷入困境,中国人工智能技术的发展与治理也将遭遇一系列新挑战。首尔峰会标志着全球人工智能治理向前迈出了关键一步,但也暴露了国际合作中的根本挑战和地缘政治的复杂性。此次会议不仅强化了全球AI安全的共识,也凸显了领导权的争夺和治理模式的分歧。首尔峰会明显显示了全球治理中的“阵营化”现象,其中G7和其盟友推动了以西方为主导的AI治理框架,而中国等非西方国家则寻求更加开放和多元的国际合作模式。这种分歧可能导致全球AI治理体系的碎片化。虽然《首尔宣言》和《安全承诺》着重于AI技术的安全和可靠性,但在全球范围内实现这些目标的途径仍存争议。不同国家对于何种措施最有效以及如何平衡技术创新与伦理考量有着不同的看法。当前AI全球治理面临的主要挑战包括技术快速发展带来的不可预测性、国际合作的复杂性以及各国在监管框架和治理目标上的差异。此外,全球南方国家的参与度和影响力不足也是一个不容忽视的问题,需要在未来的国际框架中给予更多关注和支持。此外,随着AI应用于军事和安全领域的不断扩展,国际社会亟需建立更为严格的监管机制来处理这些技术的潜在威胁。这将要求各国政府、国际组织和私营部门在确保技术使用安全和负责任的同时,加强合作,共同应对复杂的国际安全环境。为了克服首尔峰会中出现的分歧,2025年的峰会需要在现有成果的基础上构建一个更加包容和透明的国际合作框架。这包括为发展中国家提供更多的代表权和决策权,以及确保所有国家都能公平地受益于AI技术的发展。一是细化全球AI治理的规则和标准:面对快速变化的技术景观,全球治理机制需要不断适应新的技术现实。这要求各国不仅更新和细化国际行为准则,还要确保这些规则能够得到有效执行。二是促进技术共享与风险管理:未来的AI治理不仅要关注技术的安全性,还要更广泛地涉及风险管理和技术共享。这包括建立全球性的风险评估机制和增强对AI技术应用影响的监测。随着人工智能技术的不断进步和全球影响的扩大,建立一个能够适应未来挑战的全球AI治理体系变得尤为关键。全球人工智能论坛不仅是评估过往成就的机会,更是全球社会调整和强化治理结构,以应对未来不确定性和风险的重要时刻。全球各方必须共同努力,才能确保人工智能的发展符合全人类的利益,促进全球和平与繁荣。

作者|何文翔、李亚琦

来源|复旦中美友好互信合作计划