作者:吕成乐 发布时间:2026-02-19 来源:全球人工智能创新治理中心+收藏本文

编者注

在全球人工智能治理体系加速构建的当下,AI意识的存在与否及相关伦理边界,已成为绕不开的核心议题。剑桥哲学家汤姆・麦克莱兰的研究直指关键矛盾:人类对意识本质的认知空白,既让AI意识检测缺乏可靠标准,也为行业炒作留下空间,更可能引发存在性危害与伦理资源错配等问题。这一观点为全球AI治理提供了重要警示,即在追逐通用人工智能(AGI)的赛道上,各国及行业不仅需搭建监管框架,更要先厘清意识与伦理责任的关联,避免将技术幻想等同于科学事实,平衡技术创新与伦理风险,确保治理体系既适配技术发展,又坚守对生命与意识的审慎态度。

以下译文仅代表原文作者的个人观点与分析立场。

摘要

人工智能是否能拥有意识体验?这个问题的答案不应基于直觉、教条或猜测,而应建立在坚实的科学证据之上。然而,本文认为此类证据难以获取,唯一合理的立场是不可知论。当代相关文献的主要分歧存在于对人工智能意识持怀疑态度的生物学观点与持支持态度的功能主义观点之间。本文指出,这两派观点都犯了一个共同的错误,即夸大了现有证据所能说明的问题。随后,本文还探讨了这种不可知论对于人工智能意识创造所涉及的伦理问题具有何种意义。

关键词:人工智能伦理;人工智能意识;证据主义;难问题;预防原则

作者:汤姆·麦克莱兰(剑桥大学科学史与科学哲学系)

01

人工智能是否能拥有意识体验?直到最近,这还被广泛视为一个关于晦涩科幻场景的理论问题。但如今,它已被普遍认为是一个亟待关注的严肃问题。人工智能领域的跨学科文献中充斥着关于人工智能意识前景的各种提议,政府机构也开始认真对待这一可能性,公众在媒体影响下也日益将其视为紧迫问题。

图片来源:Science News Today

人们对人工智能意识的兴趣升温,核心驱动力是其蕴含的伦理意义。意识是我们道德体系的哲学基石,若人工智能是有意识的存在,强迫它为我们服务就等同于奴隶制。因此,这不仅是一个我们想要解答的问题,更是一个在道德上有义务去解答的问题。

这股研究热潮源于计算机科学和意识科学的双重进展。在计算机科学领域,大型语言模型的发展催生了看似具备意识的人工智能,相关事件让人们意识到需要可靠的 AI 意识测试方法。此外,全脑模拟、意识机制模拟、进化模拟等领域的发展,也引发了诸多关于 AI 意识的疑问。在意识科学领域,研究工具的发展和理论范围的拓展,让人们相信意识分布问题可通过科学方法解答。主流观点认为,对 AI 意识的评估应完全基于科学证据,这一证据主义原则不仅指导研究判断,更要为现实世界决策提供指引。

那么,既然我们的判断应该以证据为基础,我们对于人工智能意识的前景应该得出怎样的结论呢?不同的学者给出了不同的答案:人工智能意识支持者(AC-advocates)认为,现有证据足以让我们得出结论——合适类型的人工智能将会拥有意识;而人工智能意识否定者(AC-deniers)则认为,现有证据足以表明人工智能不太可能拥有意识。尽管大多数学者得出结论时都持谨慎态度,但本文的目的在于说明,即便是这种谨慎的结论也是站不住脚的。我们目前所掌握的证据,无论从哪个角度来看,都无法确切告知我们人工智能是否可能拥有意识,而且在短期内也不太可能做到这一点。因此,如果我们遵循证据主义原则,那么对于人工智能意识,唯一合理的立场就是不可知论。

02

2.1

可能拥有意识的人工智能候选者

本文并非为当前人工智能的意识问题主张不可知论。一方面,即使是支持者也对当前 AI 的意识持怀疑态度,且这种怀疑有充分依据;另一方面,伦理担忧更多聚焦于未来可能开发出的 AI。

因此,本文聚焦于假设中的复杂人工智能 ——“挑战性人工智能”,这类 AI 具备某些特征,若出现在有机体身上会构成意识的有力证据。同时设定,挑战性人工智能基于与当前 AI 相同的原理工作,其展现的潜在意识标记在有机体身上会被视为强有力的意识指标。

2.2

不可知论的论证过程

不可知论的整体论证过程较为简单:我们尚未获得对意识的深层解释;若缺乏深层解释,就无法为挑战性人工智能是否具有意识提供合理定论;因此,我们无法对这一问题给出合理定论。

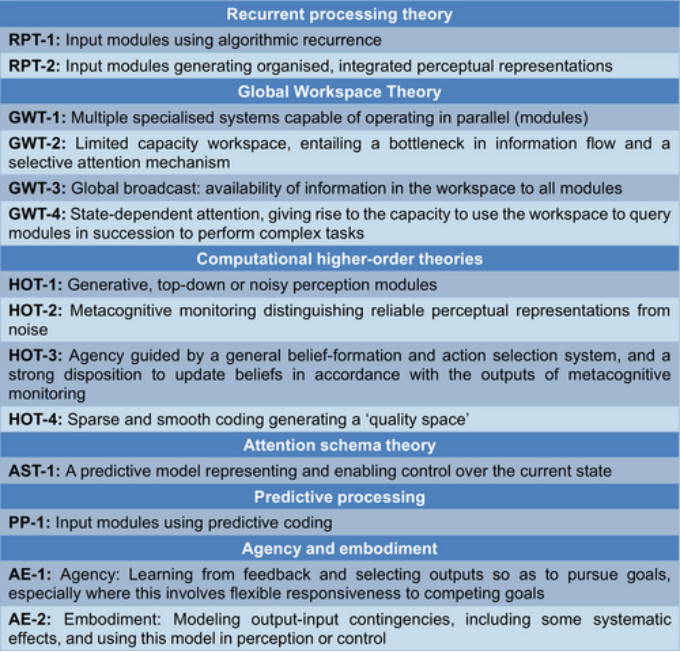

汤姆·麦克莱兰在其论文《Agnosticism about artificial consciousness》的研究中重点关注那些具有强烈意识证据的人工智能,并称其为“挑战者AI”,该图为Butlin等人列出的挑战者AI所具备的功能

图片来源:Welly Online Library 官网

深层解释能说明某一认知过程为何是有意识的而非无意识的,而现有理论都遭遇 “难问题”—— 无法解释为何特定状态会构成有意识体验而非无意识形式。现有意识理论虽有解释价值,但都未能解答这一核心谜团。

03

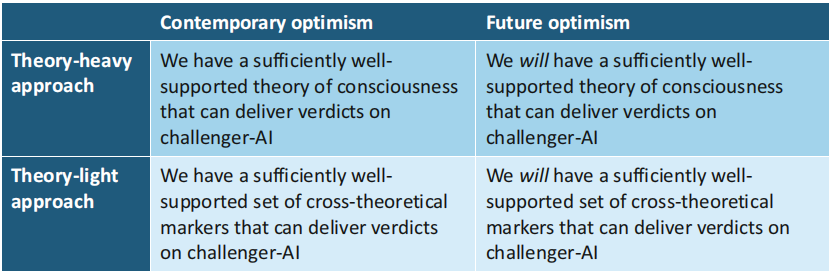

现有评估 AI 意识的方法可分为理论密集型、理论精简型,且都存在当代乐观主义与未来乐观主义的倾向,这些方法的共同点是可知论,即声称能根据证据主义原则得出关于挑战性人工智能意识的结论,但实际上都存在缺陷。

评估AI意识的四种方法

图源:Welly Online Library 官网

3.1

不可知论与理论密集型方法的对比

理论密集型方法选择特定意识理论,再据此评估实体是否具有意识。该方法首先面临理论选择过多的问题,缺乏共识导致僵局;更深层的问题是,从人类意识中获取实证支持的理论,推广到 AI 意识时会遭遇认知障碍。

理论密集型学者陷入 “证据主义困境”:若采用温和版本的理论,尊重认知障碍,就无法对 AI 意识得出结论,走向不可知论;若采用大胆版本的理论,明确意识的必要和充分条件,虽能得出结论,却违背证据主义原则。

支持 AI 意识的理论密集型学者常以计算功能主义为假设,但这一假设缺乏实证证据支持,更多是一种信念;否定 AI 意识的理论密集型学者提出的生物学理论,同样无法解答 “难问题”,其得出的结论也缺乏充分依据。

提供计算功能主义的替代方案并不等同于证明其错误,理论密集型的生物学方法同样面临证据主义困境,因此证据无法指引我们在功能主义与生物学路径间选择,也无法告知我们挑战性人工智能是否会具有意识。

3.2

不可知论与理论精简型方法的对比

理论精简型方法不采用特定意识理论,而是识别来自不同理论的一系列意识标记,以此评估 AI 意识。该方法最初具有一定优势,但其根本问题与理论密集型方法类似:意识标记的有效性基于相关理论的证据支持,而这些证据同样遭遇认知障碍,仅能表明这些特征是有机体中意识的标记,应用于 AI 缺乏依据。

理论精简型学者同样面临证据主义困境:温和的标记仅适用于有机体,大胆的标记虽适用于生物和非生物案例,却不再有实证证据支持。他们盲目推断现有理论整体能跨越认知障碍,实则所有理论都会遭遇这一问题,因此该方法也无法在不违背证据主义原则的情况下对 AI 意识得出结论。

图片来源:The Royal Society

3.3

不可知论与未来乐观主义的对比

未来乐观主义认为,未来的研究将使我们能对 AI 意识得出基于实证的结论。但这种乐观主义缺乏依据,可知论观点面临的认知障碍难以通过科学发展克服。

在 “难问题” 上,我们至今没有取得实质性进展,新的理论只是重新定位了意识的奇迹,并未降低其神秘性。基于归纳法,认为未来能对 AI 意识得出结论的乐观主义站不住脚。

我们应采取 “准强不可知论” 立场,承认存在严重的认知障碍,这些障碍可能可克服也可能不可克服。意识科学的革命或许能突破障碍,但目前没有充分理由相信这样的革命即将到来。

04

4.1

标准过高的反对意见

该反对意见认为不可知论设定的辩护标准过高,会导致过度推断。但本文支持的挑战性人工智能不可知论,并不会导致对其他案例的不可知论。

在没有深层意识解释的情况下,我们可利用人类意识知识推断其他有机体的意识标记,黑猩猩等非人类动物的意识归因处于认知障碍的合理一侧,有充分依据;而大型语言模型的意识主张,其所谓证据可被推翻,否定其意识是适当的。

样本群体和目标群体之间的差异越大,对意识评估的信心就应越低。生物和人工之间的障碍巨大,应用普通的意识归因标准,无法满足对挑战性人工智能意识评估的需求,因此不可知论并非设定了过高标准。

4.2

象牙塔式的反对意见

该反对意见认为,当实际面对挑战性人工智能时,其展现的所有外在意识迹象会让人们的疑虑消失。但这种观点存在问题:

从证据角度看,某物表现出有意识的样子仅能提供可废止的证据,而 AI 的本质构成了这种证据的废止条件,我们没有理由假设有机体中指示意识的外在迹象在无机实体中同样有效。

从人类心理学角度看,即便人们不可避免地会将意识归因于这类 AI,也不构成对不可知论的反对,好的论证有时会得出与直觉相反的结论,面对挑战性人工智能,我们不应相信直觉。

4.3

形而上学假设不合理的反对意见

有人认为不可知论依赖副现象论这一可疑的形而上学假设,但本文的论证不涉及此类形而上学承诺。有意识的状态可能就是某种特定的物理状态,且具有因果效力,问题的核心在于知道哪些物理状态是有意识的,以及 AI 的状态是否可能是有意识的,本文提出的不可知论避免了任何有问题的形而上学假设。

图片来源:Science News Today

05

5.1

不可知论面临的伦理问题

具有伦理相关性的是感受性,即具有效价的意识。感受性理论认为,所有且只有有感受性的存在物才值得伦理考量,它是进入 “道德圈” 的合理门票,但关于感受性的界限存在很大不确定性。

对于 AI,我们可评估其具有感受性的风险,再采取相应预防措施。但不可知论让我们无法判断挑战性人工智能具有意识的可能性大小,进而无法确定适当的预防措施程度,陷入了既无帮助又不可持续的道德困境。

5.2

伦理问题的解决方案

要解决这一问题,需深入思考意识与感受性的联系。意识是感受性的必要条件,但我们或许能得出这样的条件性结论:如果挑战性人工智能具有意识,它会拥有什么样的体验。

这种条件性主张足以支撑负责任的决策制定。对于若有意识则无效价的 AI,无需采取预防措施;对于若有意识则可能有负效价的 AI,可通过避免创造此类 AI 来规避道德困境。

这一原则能让我们摆脱道德困境,同时不对有用 AI 的发展施加不必要限制,只需确保 AI 的意识不会带有效价即可。不可知论与基于证据得出伦理决策并不冲突,能在对挑战性人工智能是否具有意识保持中立的同时,克服相关伦理担忧。

图片来源:Science Daily

06

在没有对意识的深层解释的情况下,评估人工智能意识可能性的努力遭遇了认知障碍。无论是支持还是怀疑人工智能意识的主流方法,都跨越了这一障碍,违背了证据主义原则。广泛存在的关于提供基于科学的人工智能意识测试的主张被夸大了。尽管意识科学的进一步发展有一天可能会克服这一障碍,但我们没有充分理由乐观地认为这会很快实现。由此产生的不可知论使得关于人工智能的伦理决策难以做出。然而,借助意识和感受性的区分,我们能够在不对人工智能是否具有意识表明立场的情况下,基于证据得出其没有感受性的归因。如果采取了适当的预防措施,这足以克服引发这场辩论的伦理担忧。本文的主要目的是为人工智能意识的不可知论提供有力支持,次要目的是表明不可知论是一个值得进一步考虑的重要选项,且它改变了这一重要辩论的格局。