作者:易洁 发布时间:2023-11-26 来源:复旦中美友好互信合作计划+收藏本文

引言

当地时间11月21日,长达100个小时的OpenAI“宫斗”终于以山姆·奥特曼(Sam Altman)的回归落幕。OpenAI官方推特账号宣布,奥特曼重返OpenAI担任首席执行官,同时组建了Bret Taylor、Larry Summers和Adam D’Angelo在内的新董事会。从被罢免与回归,有哪些值得主义的时间节点?在公司的治理困局的表现背后,如何理解行业内部的深层分歧?此次事件又将对OpenAI乃至人工智能产业造成怎样的影响?

01

11月2日,重大科技突破。当团队展示下一个重大进步时,山姆·奥特曼(Sam Altman)在场。在OpenAI的历史上,他们曾3次(最近一次是GPT-4)揭开了无知的面纱,推进了发现的边界。奥特曼已经在计划下一步的行动:筹集必要的资金,以建设所需的计算资源。

11月4日,不安情绪升级。伊尔亚·苏茨克维(Ilya Sutskever)感到不安。模型的自主性已经达到了一个令人担忧的临界点,而对齐(alignment)团队还只是在增加能力,而不是情感、对人类真正的爱。他们需要更多的时间来找出研究路径,而不是急于部署产品。

11月6日,新产品发布。奥特曼出席了OpenAI首届开发者日(Devday)。会议进行得很顺利,收到很多赞誉。接下来的几天里他们公开了包括GPTs在内的新功能。开发者日结束后,格雷格·布罗克曼(Greg Brockman)和奥特曼全力筹集资金。他们的目标是900亿美元的估值,比300亿美元提高3倍。OpenAI的招聘人员开始给谷歌员工打电话,告诉他们如果现在加入,就能在估值提高前拿到1000万至2000万美元的4年合同。

11月9日,进一步筹资。布罗克曼与法国总统伊曼纽尔·马克龙(Emanuel Macron)会面并合影留念,随后在巴黎参加投资者会议。OpenAI现在达到了主权财富基金、欧洲家族资金规模的投资。同日,微软因安全担忧暂时限制了员工使用 ChatGPT。

11月13日,首次公开GPT-5消息。奥特曼在伦敦接受《金融时报》采访时,首次确认GPT-5的工作已经开始,而且表示他正在筹集资金。

11月14日,暂停ChatGPT订阅。因为开发者日后使用量激增,计算资源已经完全耗尽,OpenAI暂停ChatGPT订阅。

11月16日,APEC CEO峰会和秘密会议(无考证)。APEC CEO峰会上,奥特曼证实了11月4日(关于模型能力)的“下一步发现”。当晚,伊尔亚发信息给奥特曼要求第二天中午见面。由于米拉·穆拉蒂(Mira Murati)在次日的董事会前已被通知她将接任CEO,表明信息发出前,肯定已经有一个秘密的董事会会议举行(无考证),董事会中3位独立成员被伊尔亚展示的“某些东西”说服了。

11月17日,董事会会议罢免奥特曼CEO职位。上午10点,董事会会议开始。Ilya带领两名23岁的员工工程师(谣传)向董事会描述进展和危险。当他说他们不应该筹集资金,不应该扩大规模,以及奥特曼在未经董事会同意的情况下外出路演进行筹资时,会议变成了一场争吵。奥特曼指出,作为首席执行官,他必须走在团队的前面,并根据团队的需求提前管理信息流,并指出他们需要更多的钱来建造更多的数据中心。伊尔亚大发脾气,事情达到了高潮,董事会投票结果导致奥特曼被解雇CEO一职并被踢出董事会。布罗克曼也被降级。同日,OpenAI CEO由技术主管米拉·穆拉蒂临时接任。

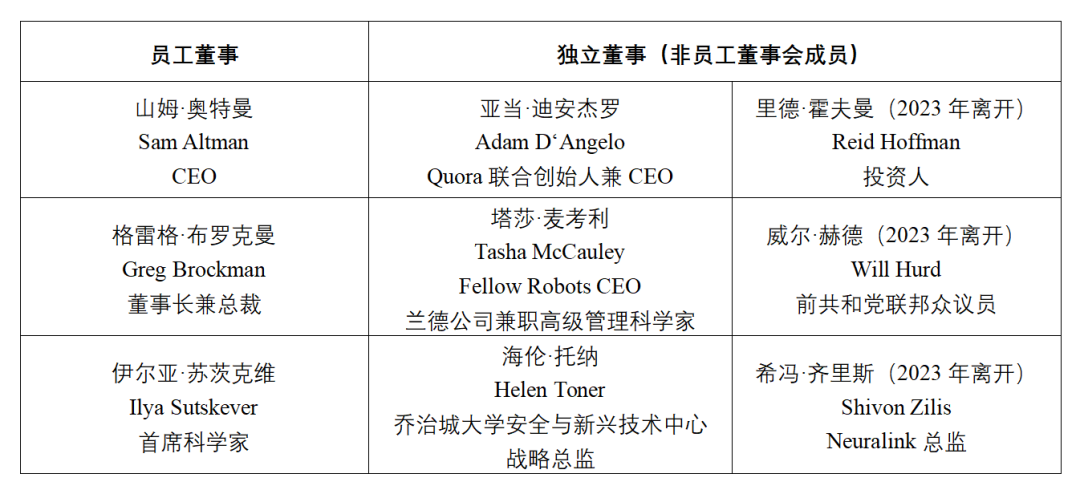

11月17日罢免会议时董事会成员情况

奥特曼代未参会的布罗克曼投票,最终以4:2的投票结果罢免奥特曼CEO职位。

从左到右依次为米拉·穆拉蒂、山姆·奥特曼、格雷格·布罗克曼和伊尔亚·苏茨克维。

图源:《纽约时报》

11月18日,多方施压下推动奥特曼回归谈判。Tiger Global、红杉资本、Thrive Capital等主要投资者与微软和奥特曼联系,并向董事会施压;微软扣留云计算信用额度进行施压;高级研究人员对奥特曼被罢免一事表示不满。OpenAI董事会正在与奥特曼讨论重返公司担任CEO的事宜,董事会原则上同意辞职并允许奥特曼和布罗克曼回归。

11月19日晚,有关奥特曼回归的谈判破裂,前Twitch老板埃米特·谢尔(Emmett Shear)接任OpenAI CEO职位。

11月20日,奥特曼和布罗克曼加入微软。同日,包括苏茨克维和米拉在内的超过500名员工签署联合信(最终有743名员工签字),表示除非奥特曼复职,否则他们将离开OpenAI到微软工作,奥特曼发推回应。

奥特曼与苏茨克维在社交软件X(原推特)上的互动

图源:X

11月21日,谈判结束。Sam Altman回归OpenAI担任CEO,并组建新董事会:成员包括布莱特·泰勒(Bret Taylor,担任主席)、劳伦斯·亨利·萨默斯(Larry Summers)和亚当·迪安杰罗(Adam D'Angelo)。奥特曼发推,庆祝事件结束,并表示要加强跟微软的合作。

02

1

非营利组织的诞生(2015年-2017年)

2015年,作为当年的AI巨头的谷歌DeepMind,发布了AlphaGo横扫围棋界各大顶尖高手,硅谷的商业精英们感受了AI发展对人类可能带来的威胁。在此背景下,硅谷顶级初创企业孵化器Y Combinator CEO奥特曼、支付公司Stripe前技术高管布罗克曼、原谷歌大脑项目科学家苏茨克维、特斯拉CEO埃隆·马斯克与其他九人共同创建了非营利性AI组织——OpenAI。他们创立了人工智能实验室,并表示自己与谷歌和其他科技巨头不同,不会受商业激励的驱动,而是秉承着开放(OpenAI中的Open正有此意)态度,以开源的方式吸纳优秀开发者帮助公司技术迭代。

官网上仍记录着OpenAI初创至今的愿景与使命:“OpenAI的愿景是确保人工智能造福全人类,其使命是保证人工智能发展的安全性和普惠性。我们致力于开发出一种强大且友善的人工智能系统,以帮助人们解决重大问题,并确保这种技术不仅属于少数人的特权。他们致力于推动人工智能的研究和发展,同时注重对其应用的责任和伦理问题,以促进一个更加公正和包容的人工智能时代的到来。”

2

启动融资与商业化转型(2018年-2019年)

然而宏大愿景背后离不开金钱的支撑。随着 OpenAI 规模的扩大,其成本开始快速上升。除了以数百万美元的薪水聘请超级明星AI研究人员之外,OpenAI需要消耗大量资金来训练大语言模型(LLM),计算成本呈指数级增长。尽管马斯克捐献了1亿美元,但初始捐赠和首轮融资金额远不足够支撑OpenAI长期的发展。根据2020年发表于MIT Technology Review上的采访报道,OpenAI联合创始人Greg Brockman称,公司事实上早在2017年就意识到保持非营利组织在财务上是不可持续的。一场围绕商业扩张与公益非营利愿景的争论已悄然打响,并逐渐演化为公开的斗争。

2018年,马斯克以“为避免特斯拉与OpenAI在人工智能领域的冲突”的说法,与奥特曼分道扬镳,他表示出对OpenAI运作方式的担忧,认为该公司没有足够关注人工智能可能带来的风险,而是过度关注商业应用。而在马斯克离开董事会之际,奥特曼正式辞去Y Combinator CEO的职位,专注投身于Open AI的商业化转型——2019年3月,OpenAI成立了有盈利上限(capped profit,超出上限的利润将流向非营利部门)的有限合伙企业OpenAI, L.P.,吸引了Khosla Ventures、Reid Hoffman foundation两大投资方,并于同年7月获得了微软的10亿美元投资以及用Azure云服务器运行其模型的许可。

3

全面商业化与重大技术突破(2020年至今)

2020年,OpenAI顺利推出GPT-3,并发布了第一个商业化产品OpenAI API,由此正式开始商业化运作,其代码也不再开源。据《纽约时报》消息,部分员工正是在此时认为奥特曼和布洛克曼在推出新产品时可能过于激进,他们执着于大刀阔斧地商业化融资,为了有利可图的交易而不断将安全研究边缘化。结果是,以达里奥·阿莫迪(Dario Amodei)为首的部分员工在2020年离开了OpenAI,并创办了AI实验室Anthropic。

奥特曼持续融资,与微软联系日益密切,这助力了OpenAI以“烧钱”的方式高速推动技术发展,OpenAI L.P.也改组为OpenAI Global, LLC,为投资方提供更多的回报。在接下来两年内,OpenAI接连推出了DALL-E、GPT-3、ChatGPT三个关键产出,而2023年3月推出的GPT-4更是在性能方面一骑绝尘。

然而在产品与商业化高歌猛进之时,最初为公益愿景而建立的董事会(《福布斯》将其戏称为“科技向善长老会”),却仍然对公司的领导层具有“绝对”的控制。在里德·霍夫曼(Reid Hoffman)、希冯·齐里斯(Shivon Zilis)和威尔·赫德(Will Hurd)离开董事会后,研发技术突破带来的隐忧,使得OpenAI商业扩张和非营利组织架构的张力进一步加剧,公司核心层的矛盾开始集中爆发于奥特曼、布罗克曼和苏茨克维三人的愿景鸿沟之中。

截至发文时OpenAI的组织架构。

底图源自其官网的Structure

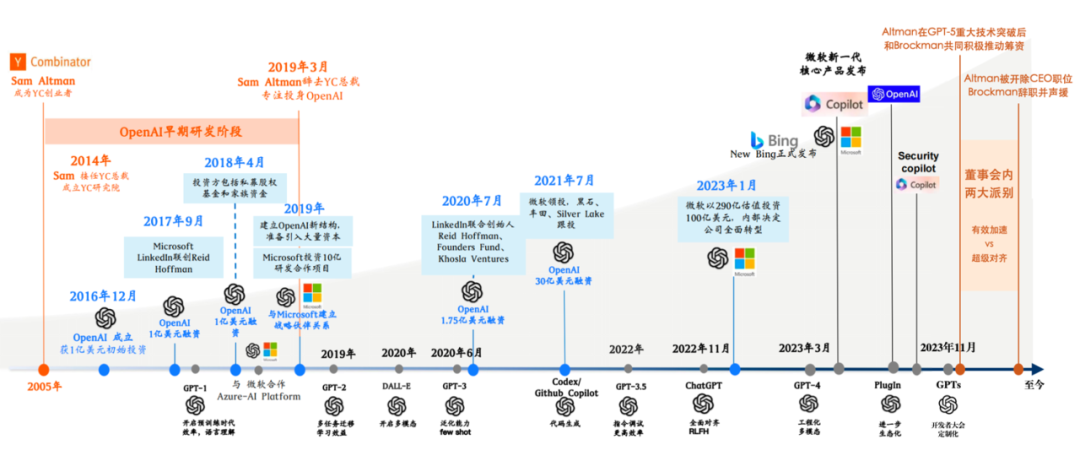

Sam Altman和Open AI大事件时间线梳理。

此图为笔者在陆奇先生5月7日《新范式 新时代 新机会》北京场演讲的底图上做了少许后续补充所得。

底图来源:https://mp.weixin.qq.com/s/La9004jqyYBlBq9Qrrv15w

03

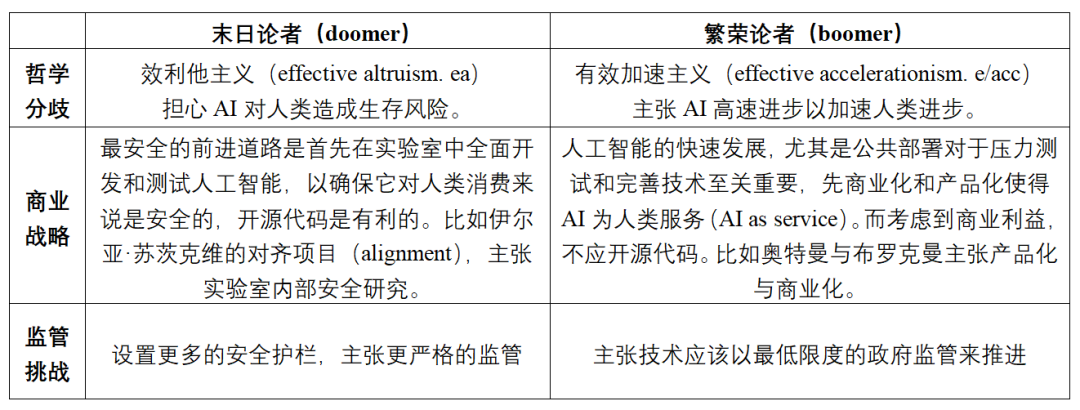

据《经济学人》、《信息报》与法国科技媒体BFM Tech分析,以OpenAI董事会的内部分歧,事实上折射出人工智能领域内“末日论者”(doomer)和“繁荣论者”(boomer)两大阵营间的深层矛盾——以研究者之间哲学与价值的“文化战争”为起点,逐步上升为商业利益层面的战略分歧,又进一步辐散为政府决策者们以“安全与发展”为框架的辩论。

末日论者与繁荣论者的三重辩论。

图源:笔者自制

1

哲学分歧:

有效利他主义vs有效加速主义

末日论者(Doomer)源自于人工智能产业中的悲观者。多年来,部分人工智能从业者一直担心更强大的模型可能会被错误的人滥用,例如开发生物武器、生成令人信服的深度伪造品或入侵关键基础设施。这些系统可能会变得自治并变得失控,最终以牺牲人类为代价。

而近年来“有效利他主义”(effective altruism,简称ea)思潮的兴起,使得这种悲观理念被一种更具体系性的哲学与宗教价值包裹起来。这一思想的核心在于运用理性分析与科学证据来寻找改善世界的最有效方法,主张要优先消除人类面临的最大威胁——存在性风险(existential risk)。在实际行动中,他们强调使用证据和推理来优化人工智能对人类的好处,倡导谨慎推进人工智能,确保发展符合道德标准和社会福祉。这并不意味着扼杀创新,而是强调要将道德考虑纳入发展过程。探索人工智能中的利他主义如何与创新共存,使技术能够在不损害安全或道德完整性的情况下,解决全球问题并提高生活质量。

繁荣论者(Boomer)则秉持对人工智能的发展秉持着乐观的态度。他们拥护一种名为“有效加速主义”(effective accelerationism,简称e/acc)的世界观。根据有效加速主义官网,该主义植根于对热力学第二定律的信念,即宇宙本身是一个创造生命并不断扩张的优化过程,而其前进的引擎是技术资本。他们认为这种进步无法停止,历史的棘轮只会朝一个方向转动。因此,不仅应该允许AI的发展不受阻碍地进行,而且应该加快发展。这并不意味着,这种哲学的许多支持者支持负责任的加速主义,它从一开始就包含了道德考虑。挑战在于展示快速创新如何与强有力的安全措施和道德远见共存。

据《纽约时报》报道,尽管奥特曼总是小心翼翼地跨越乐观和担忧之间的界限,表示相信人工智能最终会造福人类,同时也同意它需要护栏和周到的设计来确保其安全,但一些行业人士认为,OpenAI已经在奥特曼的引领下倾斜到“有效加速主义”的阵营,逐渐偏离了最初的使命——对抗大型科技公司。屠龙少年已成恶龙。风险资本家、信念创始人Sarah Guo指出:“老实说,看到这样一个改变世界的组织被撕裂令人心碎。前任人工智能革命的旗手,房间里无懈可击的巨人竟如此脆弱,新的领导层将为他们提供建立客户和员工信任的工作,这彻底改变了战略格局。”

2

商业战略:

产品安全研究优先vs产品市场化优先

这种哲学分歧上升到商业战略层面,体现为伊尔亚·苏茨克“产品安全研究优先”,与奥特曼和布罗克曼“产品市场化优先”的分歧。

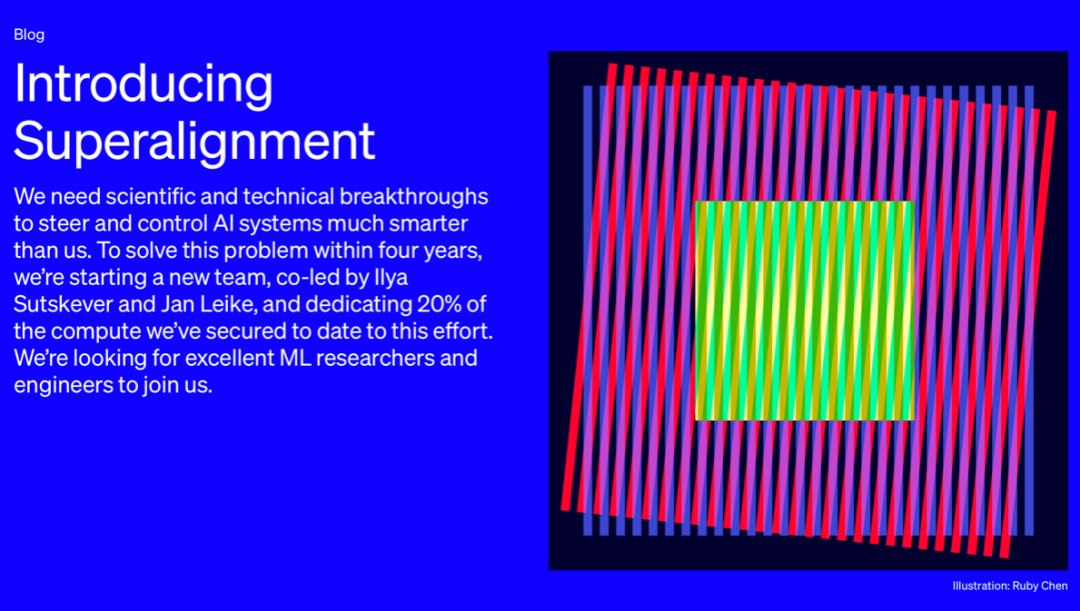

有效利他主义者认为,过早地引入商业化与大量资本,会放大技术蕴藏的风险,所以在商业战略上,最安全的前进道路是首先在实验室中全面开发和测试人工智能,并通过开源代码的方式寻求社会各界的监督。今年夏天,OpenAI核心层中主要负责研发条线的伊尔亚·苏茨克维与研究员Jan Leike成立了“超级对齐”团队(确保AI系统的价值观能否与人类保持一致),致力于研究防止其人工智能系统运行异常的技术解决方案。他们曾指出,超级智能可能导致人类丧失权力甚至灭绝。OpenAI在一篇博客文章中表示,他们将投入五分之一的计算资源来解决来自“超级智能”的威胁。

OpenAI超级对齐项目。

图源:OpenAI官网

而“有效加速主义者”则认为公共部署对于压力测试和完善技术至关重要,因此优先选择商业化和产品化使得AI为人类服务(AI as service)的道路。奥特曼和布罗克曼,希望更快地将新成果部署开放给公众使用。奥特曼曾指出,如果AGI(Artificial general Intelligence,通用人工智能)被创建,它可以通过增加丰富性来帮助我们提升人类水平,加速全球经济并帮助新的科学发现,从而帮助对抗全球变暖或殖民太空。而考虑到商业利益,不应开源代码。

人工智能领域各大公司在开源与否上的立场。

图源:《信息报》(The Information)

3

监管挑战:

更多安全护栏与监管vs设置监管底线促发展

根据上文哲学与商业层面的分析,末日论者似乎应设置更多的安全护栏,主张更严格的监管,而繁荣论者则更倾向于主张技术应该以最低限度的政府监管来推进。然而考虑到生成式人工智能领域的初创公司与大型科技巨头在实力与资金上的差异,以及投资者与科技精英内部的更多利益分歧,他们在游说与应对监管机构时,在“安全与发展”的框架下呈现出更复杂的谱系。

《华盛顿邮报》指出,在人工智能繁荣时期,微软、Twitch和Twitter等科技公司一直在解雇他们的人工智能道德团队,繁荣论者占了上风,但决策者和公众一直在倾听悲观者的话语。前白宫政策顾问Suresh Venkatasubramanian帮助制定了人工智能权利法案的蓝图,他告诉VentureBeat,最近关于ChatGPT能力的夸张说法是围绕生成人工智能的“有组织的恐惧运动”的一部分,对政策制定产生了极大影响。被谷歌解雇的黑人女研究员Timnit Gebru在欧洲议会就缓慢的人工智能运动的必要性发表了讲话,他指出社会的安全是第一位的。

然而在行业内部,分歧则更加复杂,大型科技公司又与政府存在更密切的关系。今年5月,在巨大的国内外监管呼吁下,OpenAI CEO山姆·奥特曼(Sam Altman)曾在美国国会就人工智能技术的潜在风险参加听证会,并首次公开呼吁政府对生成式人工智能进行监管和干预。他的配合态度无疑将对生成式AI产业起到示范作用,对政府和社会的治理起到积极作用。微软、谷歌和亚马逊也决定与政府合作而不是对抗。与此同时,投资者与大部分初创公司则认为,这种与政府的紧密关系和对监管的“过度呼吁”是对创新精神的背叛。这会导致最终使拥有最多游说者和律师的公司受益,使微软和谷歌等大型企业对该技术产生更大的影响力。美国Hugging Face和法国Mistral AI在内的一系列初创公司都主张监管不那么严格,该技术应该以最低限度的政府监管来推进,以便使新兴公司存活发展,并为人们提供有用的工具。而投资者安德森·霍洛维茨(Andreessen Horowitz)一直试图让立法者相信过度监管的危险。他们的合作伙伴认为,如果初创公司无法获得开源人工智能,他们将别无选择,只能从大型科技公司购买软件。

04

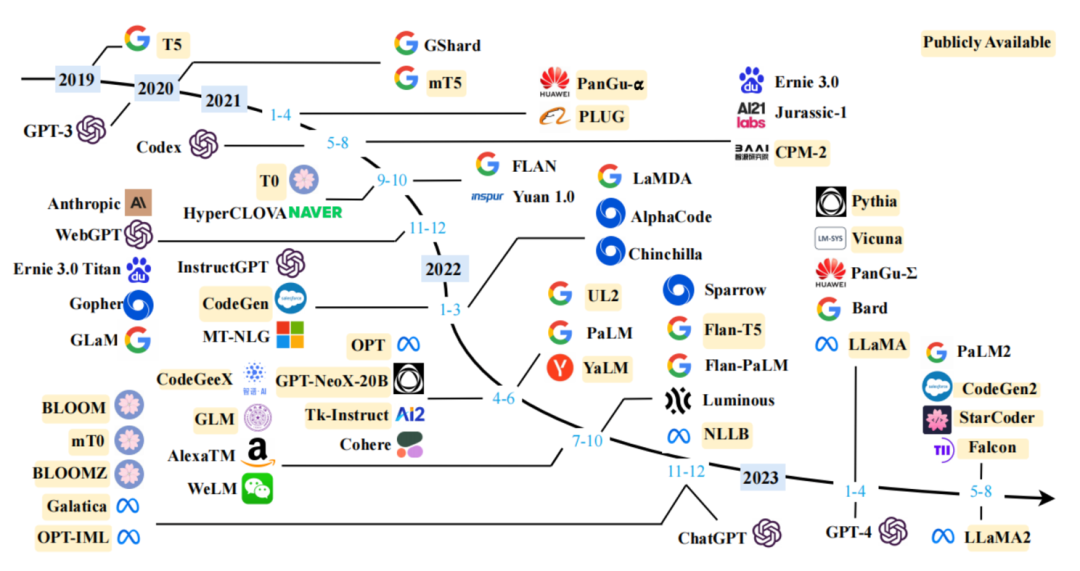

今年9月发布报告中对大语言模型发展的梳理。

图源:A Survey on Large Language Models (Wayne Xin Zhao et al.)

从竞争层面来看,OpenAI风波短期内造成的人员流动和资金撤离,或利好与之存在竞争关系的公司。目前在大型科技公司中,谷歌已经推迟了Gemini模型的发布,很可能会利用这种情况缩小OpenAI的领先优势;Meta Platforms的开源Llama模型已成为OpenAI和其他公司闭源模型的强大替代品,他们可能从中受益;微软也正在以高额签约金的方式吸纳OpenAI科技人才。而对于初创公司而言,开发大语言模型的初创公司Cohere已经收到了不请自来的投资者对其下一次融资的兴趣;另一家人工智能公司Adept,表示正试图在周五事件发生后的混乱中挖走OpenAI员工。

此外,此次事件也将推动美国商业界对“公益与商业”二者关系的思考,长期来看,将让投资者对其他治理结构不寻常的公司更加谨慎。原先董事会成员中的塔莎·麦考利与海伦·托纳都与慈善机构和“有效利他主义”关系紧密,被视作此次风波中的重大不确定因素之一。而与之相类似,OpenAI的最大初创竞争对手Anthropic也拥有一个由具有人工智能安全、国家安全和公共政策背景的个人组成的独立的五人信托机构,该信托有权在四年内选举 Anthropic董事会的大多数成员,据《信息报》分析,他们未来也可能面临治理结构的变革。

作者|易洁

来源|复旦中美友好互信合作计划